Úvod do architektúry veľkých dát

Pokiaľ ide o správu veľkých údajov a vykonávanie komplexných operácií s týmito rozsiahlymi údajmi, je potrebné používať nástroje a techniky veľkých údajov. Keď hovoríme s použitím veľkých dátových nástrojov a techník, máme na mysli to, že žiadame využitie rôznych softvérov a postupov, ktoré ležia v ekosystéme veľkých údajov a jeho sfére. Neexistuje žiadne všeobecné riešenie, ktoré je poskytované pre každý prípad použitia, a preto musí byť vytvorené a vyrobené efektívnym spôsobom podľa obchodných požiadaviek konkrétnej spoločnosti. Preto je potrebné využívať rôzne architektúry veľkých dát, pretože kombinácia rôznych technológií povedie k dosiahnutiu výsledného prípadu použitia. Zavedením pevnej architektúry je možné zabezpečiť, aby sa pre požadovaný prípad použitia poskytlo realizovateľné riešenie.

Čo je architektúra veľkých dát?

- Táto architektúra je navrhnutá tak, aby zvládala proces prijímania, spracovanie údajov a analýza údajov, ktorá je príliš veľká alebo zložitá na to, aby zvládla tradičné systémy správy databáz.

- Rôzne organizácie majú pre svoje organizácie rôzne prahy, niektoré majú pre niekoľko stoviek gigabajtov, zatiaľ čo pre iné dokonca niektoré terabajty nie sú dosť dobré na to, aby boli prahovou hodnotou.

- V dôsledku tejto udalosti, keď sa pozriete na komoditné systémy a skladovanie komodít, sa výrazne znížili hodnoty a náklady na skladovanie. Existuje veľké množstvo údajov, ktoré si vyžadujú rôzne spôsoby starostlivosti.

- Niektoré z nich sú údaje o dávkach, ktoré prichádzajú v konkrétnom čase, a preto je potrebné naplánovať úlohy podobným spôsobom, zatiaľ čo iné patria do triedy streamingu, kde je potrebné vybudovať plynovod v reálnom čase, aby vyhovoval všetkým požiadavky. Všetky tieto výzvy sú riešené architektúrou veľkých dát.

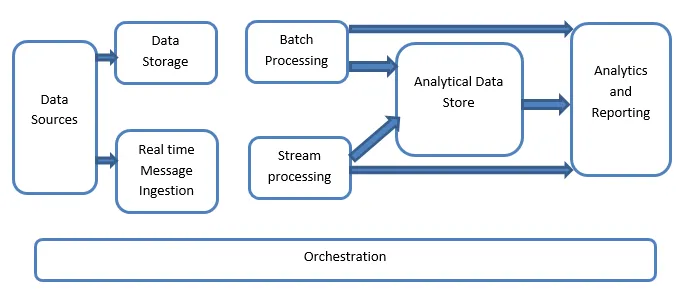

Vysvetlenie architektúry veľkých dát:

Systémy veľkých údajov zahŕňajú viac ako jeden typ pracovnej záťaže a sú všeobecne klasifikované takto:

- Tam, kde sú veľké zdroje údajov v pokoji, ide o dávkové spracovanie.

- Veľké spracovanie údajov v pohybe pre spracovanie v reálnom čase.

- Preskúmanie interaktívnych veľkých dátových nástrojov a technológií.

- Strojové učenie a prediktívna analýza.

1. Zdroje údajov

Zdroje údajov zahŕňajú všetky tie zlaté zdroje, z ktorých je vybudovaný plynovod na extrakciu údajov, a preto sa dá povedať, že je to východiskový bod veľkého dátového potrubia.

Príklady zahŕňajú:

(i) Dátové súbory aplikácií, ako sú napríklad relačné databázy

ii) súbory, ktoré vytvára množstvo aplikácií a sú prevažne súčasťou statických systémov súborov, ako sú súbory servera servera generujúce protokoly.

iii) zariadenia internetu vecí a iné zdroje údajov založené na reálnom čase.

2. Ukladanie údajov

Zahŕňa to údaje, ktoré sú spravované pre dávkové operácie a sú uložené v obchodoch so súbormi, ktoré sú distribuované v prírode a sú tiež schopné uchovávať veľké objemy veľkých súborov rôznych formátov podporovaných formátom. Nazýva sa to údajové jazero. Toto spravidla tvorí časť, kde sú k dispozícii naše úložné priestory Hadoop, ako sú HDFS, Microsoft Azure, AWS, GCP, spolu s kontajnermi typu blob.

3. Spracovanie šarže

Všetky údaje sú rozdelené do rôznych kategórií alebo častí, ktoré využívajú dlhodobé úlohy používané na filtrovanie a agregáciu a tiež na prípravu údajov o spracovanom stave na analýzu. Tieto úlohy zvyčajne využívajú zdroje, spracovávajú ich a poskytujú výstup spracovaných súborov do nových súborov. Dávkové spracovanie sa vykonáva rôznymi spôsobmi použitím úloh Úľa alebo úloh založených na U-SQL alebo použitím príkazov Sqoop alebo Pig spolu s vlastnými úlohami redukcie máp, ktoré sú všeobecne napísané v ktorejkoľvek z Java alebo Scala alebo iných jazyk ako Python.

4. Prijímanie správ v reálnom čase

To na rozdiel od dávkového spracovania zahŕňa všetky tie systémy streamovania v reálnom čase, ktoré obstarávajú dáta, ktoré sa generujú postupne a v pevnom vzore. Toto je často jednoduchý dátový server alebo obchod zodpovedný za všetky prichádzajúce správy, ktoré sú vynechané vo vnútri zložky nevyhnutne použité na spracovanie údajov. Existuje však väčšina riešení, ktoré vyžadujú potrebu prijímacieho skladu založeného na správach, ktorý funguje ako vyrovnávacia pamäť správ a ktorý tiež podporuje spracovanie na báze stupnice, poskytuje porovnateľne spoľahlivé doručenie spolu s ďalšími sémantikou frontov správ. Možnosti zahŕňajú napríklad Apache Kafka, Apache Flume, Centrá udalostí od Azure atď.

5. Spracovanie toku

Existuje mierny rozdiel medzi prijímaním správ v reálnom čase a spracovaním toku. Prvý z nich berie do úvahy prijaté údaje, ktoré sa zozbierajú najskôr a potom sa použijú ako nástroj na predplatenie publikovania. Na druhej strane spracovanie toku sa používa na spracovanie všetkých údajov o streamovaní, ktoré sa vyskytujú v oknách alebo prúdoch, a potom ich zapíše do výstupného umývadla. To zahŕňa Apache Spark, Apache Flink, Storm atď.

6. Dátové úložisko na základe analýzy

Toto je dátový sklad, ktorý sa používa na analytické účely, a preto sa už spracované údaje spytujú a analyzujú pomocou analytických nástrojov, ktoré môžu zodpovedať riešeniam BI. Dáta môžu byť tiež prezentované pomocou technológie dátového skladu NoSQL, ako je HBase, alebo akýmkoľvek interaktívnym využitím databázy úľa, ktorá môže poskytnúť abstrakciu metadát v dátovom sklade. Nástroje zahŕňajú Hive, Spark SQL, Hbase atď.

7. Podávanie správ a analýza

Štatistiky sa musia generovať o spracovaných údajoch, čo sa efektívne dosahuje pomocou nástrojov na tvorbu výkazov a analýz, ktoré využívajú zabudovanú technológiu a riešenie na vytváranie užitočných grafov, analýz a štatistík užitočných pre podniky. Nástroje zahŕňajú Cognos, Hyperion, atď.

8. Orchestrácia

Veľké riešenia založené na údajoch pozostávajú z operácií súvisiacich s údajmi, ktoré majú opakujúci sa charakter a sú tiež zapuzdrené do pracovných postupov, ktoré môžu transformovať zdrojové údaje a tiež prenášať údaje medzi zdrojmi, ako aj klesať a zaťažovať v obchodoch a tlačiť do analytických jednotiek. Medzi príklady patrí Sqoop, oozie, továreň na dáta atď.

záver

V tomto príspevku čítame o architektúre veľkých dát, ktorá je nevyhnutná na implementáciu týchto technológií v spoločnosti alebo organizácii. Dúfam, že sa vám náš článok páčil.

Odporúčané články

Toto bol sprievodca architektúrou veľkých dát. Tu diskutujeme o tom, čo sú veľké údaje? a tiež sme vysvetlili architektúru veľkých dát spolu s blokovým diagramom. Viac informácií nájdete aj v ďalších navrhovaných článkoch -

- Veľké dátové technológie

- Analýza veľkých dát

- Kariéra v oblasti veľkých dát

- Otázky týkajúce sa rozhovoru s veľkými dátami

- Top 8 zariadení IoT, ktoré by ste mali vedieť

- Typy pripojení v programe Spark SQL (príklady)