Prehľad inštalácie Hadoop

Nasledujúci článok, Inštalácia softvéru Hadoop, obsahuje prehľad najbežnejších modulov kľúčov rámca Hadoop a postupnú inštaláciu systému Hadoop. Apache Hadoop je zbierka softvéru, ktorá umožňuje spracovanie veľkých množín údajov a distribuovaného úložiska v klastri rôznych typov počítačového systému. Hadoop v súčasnosti zostáva najpoužívanejšou analytickou platformou pre veľké dáta („Sanchita Lobo, autor na blogu Analytics Training“, nd).

Hadoop Framework

Rámec Apache Hadoop pozostáva z nasledujúcich kľúčových modulov.

- Apache Hadoop Bežné.

- Distribuovaný systém súborov Apache Hadoop (HDFS).

- Apache Hadoop MapReduce

- Apache Hadoop YARN (ďalší manažér zdrojov).

Apache Hadoop Bežné

Modul Apache Hadoop Common pozostáva zo zdieľaných knižníc, ktoré sa spotrebúvajú vo všetkých ostatných moduloch vrátane správy kľúčov, generických vstupno-výstupných balíkov, knižníc na zhromažďovanie metrík a pomocných programov pre register, zabezpečenie a streamovanie.

HDFS

HDFS je založený na súborovom systéme Google a je štruktúrovaný tak, aby fungoval na lacnom hardvéri. HDFS toleruje chyby a je určený pre aplikácie, ktoré majú veľké súbory údajov.

MapReduce

MapReduce je inherentný model paralelného programovania na spracovanie údajov a spoločnosť Hadoop môže spúšťať programy MapReduce napísané v rôznych jazykoch, ako je napríklad Java. MapReduce pracuje rozdelením spracovania do fázy mapy a redukuje fázu.

Apache Hadoop YARN

Apache Hadoop YARN je základnou súčasťou a je technológiou správy zdrojov a plánovania úloh v distribuovanom spracovateľskom rámci Hadoop.

V tomto článku budeme diskutovať o inštalácii a konfigurácii Hadoop 2.7.4 na jednom klastri uzlov a otestujeme konfiguráciu spustením programu MapReduce s názvom wordcount, aby sa spočítal počet slov v súbore. Ďalej sa pozrieme na niekoľko dôležitých príkazov systému súborov Hadoop.

Kroky na inštaláciu Hadoop

Nasleduje prehľad úloh zahrnutých v konfigurácii Apache Hadoop.

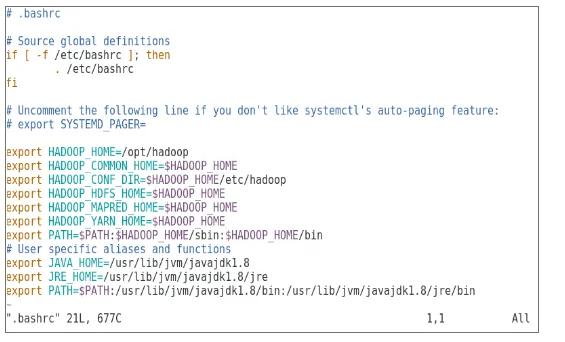

Úloha 1: Prvá úloha v inštalácii Hadoop zahŕňala nastavenie šablóny virtuálneho stroja, ktorý bol nakonfigurovaný s Cent OS7. Balíky ako Java SDK 1.8 a Runtime Systems požadované na spustenie Hadoop boli stiahnuté a premenná prostredia Java pre Hadoop bola nakonfigurovaná úpravou bash_rc.

Úloha 2: Balík Hadoop Release 2.7.4 bol stiahnutý z webovej stránky apache a bol extrahovaný do priečinka opt. Pre ľahký prístup bol potom premenovaný na Hadoop.

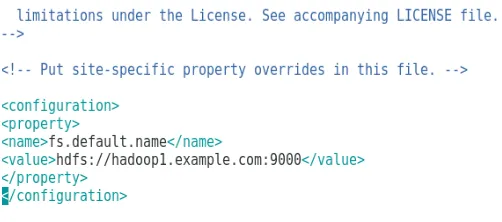

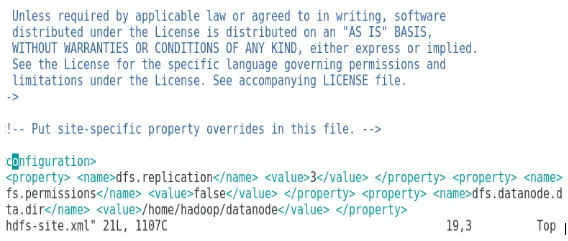

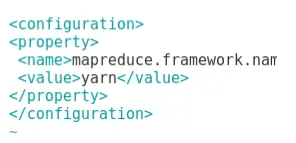

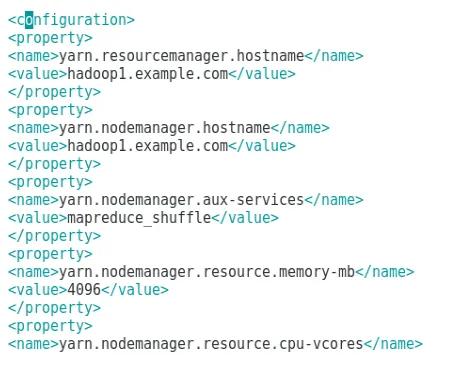

Úloha 3: Keď boli balíčky Hadoop extrahované, ďalším krokom bolo nakonfigurovanie premennej prostredia pre používateľa Hadoop nasledované konfiguráciou súborov XML uzla Hadoop. V tomto kroku bol NameNode nakonfigurovaný v rámci core-site.xml a DataNode bol nakonfigurovaný v hdfs-site.xml. Správca zdrojov a správca uzlov boli nakonfigurované v priadzi-site.xml.

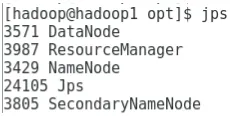

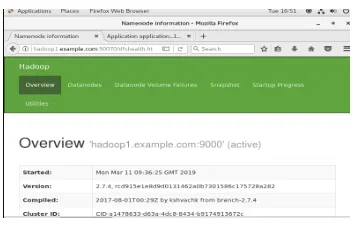

Úloha 4: Firewall bol vypnutý, aby sa spustili YARN a DFS. Príkaz JPS sa použil na overenie, či sú na pozadí spustené príslušné démony. Číslo portu pre prístup k Hadoop bolo nakonfigurované na http: // localhost: 50070 /

Úloha 5: Na overenie a testovanie systému Hadoop sa použilo niekoľko nasledujúcich krokov. Za týmto účelom sme vytvorili dočasný testovací súbor vo vstupnom adresári pre program WordCount. Na výpočet počtu slov v súbore sa použil program na zníženie mapy Hadoop-MapReduce-example2.7.4.jar. Výsledky boli vyhodnotené na localhost a boli analyzované protokoly predloženej žiadosti. Všetky predložené aplikácie MapReduce si môžete prezrieť v online rozhraní, predvolené číslo portu je 8088.

Úloha 6: V záverečnej úlohe predstavíme niekoľko základných príkazov systému súborov Hadoop a skontrolujeme ich použitie. Uvidíme, ako je možné vytvoriť adresár v systéme súborov Hadoop, aby sme vymenovali obsah adresára, jeho veľkosť v bajtoch. Ďalej uvidíme, ako odstrániť konkrétny adresár a súbor.

Výsledky v inštalácii Hadoop

Nasledujúci text zobrazuje výsledky každej z vyššie uvedených úloh:

Výsledok úlohy 1

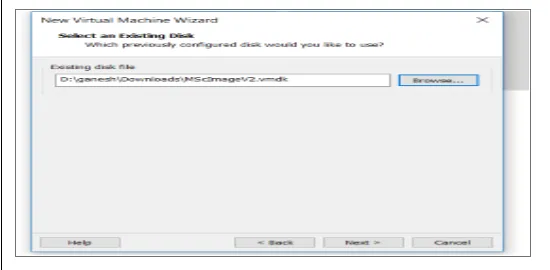

Nový virtuálny stroj s obrazom cenOS7 bol nakonfigurovaný na spustenie Apache Hadoop. Obrázok 1 ukazuje, ako bol obraz CenOS 7 nakonfigurovaný vo virtuálnom stroji. Obrázok 1.2 zobrazuje konfiguráciu premennej prostredia JAVA v rámci .bash_rc.

Obrázok 1: Konfigurácia virtuálneho počítača

Obrázok 1.2: Konfigurácia premennej prostredia Java

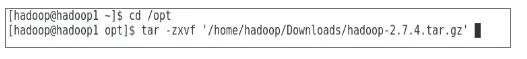

Výsledok úlohy 2

Obrázok 2 zobrazuje úlohu vykonanú za účelom extrahovania balíka Hadoop 2.7.4 do priečinka opt.

Obrázok 2: Extrakcia balíka Hadoop 2.7.4

Výsledok úlohy 3

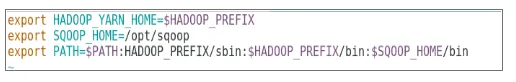

Obrázok 3 zobrazuje konfiguráciu premennej prostredia pre používateľa Hadoop, obrázky 3.1 až 3.4 zobrazujú konfiguráciu súborov XML vyžadovaných pre konfiguráciu Hadoop.

Obrázok 3: Konfigurácia premennej prostredia pre používateľa Hadoop

Obrázok 3.1: Konfigurácia core-site.xml

Obrázok 3.2: Konfigurácia hdfs-site.xml

Obrázok 3.3: Konfigurácia súboru mapred-site.xml

Obrázok 3.4: Konfigurácia súboru priadza-site.xml

Výsledok úlohy 4

Obrázok 4 ukazuje použitie príkazu jps na kontrolu príslušných démonov bežiacich na pozadí a nasledujúci obrázok zobrazuje online používateľské rozhranie Hadoop.

Obrázok 4: Príkaz jps na overenie spustených démonov.

Obrázok 4.1: Prístup k online rozhraniu Hadoop na porte http://hadoop1.example.com:50070/

Výsledok úlohy 5

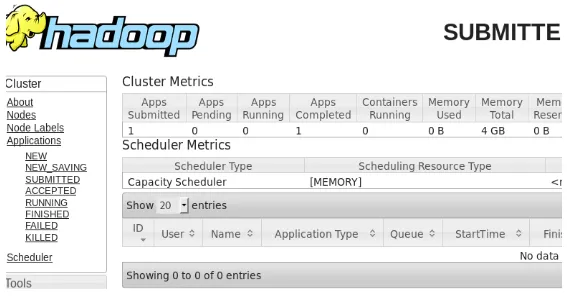

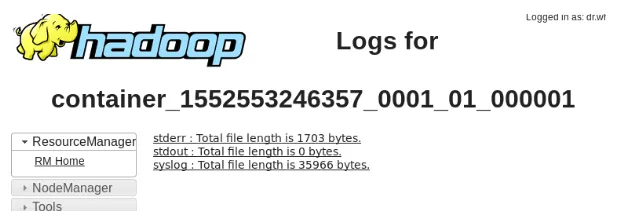

Obrázok 5 zobrazuje výsledok programu MapReduce nazvaný wordcount, ktorý počíta počet slov v súbore. Nasledujúcich pár obrázkov zobrazuje online užívateľské rozhranie správcu prostriedkov YARN pre zadanú úlohu.

Obrázok 5: Výsledky programu MapReduce

Obrázok 5.1: Odoslaná aplikácia na zníženie mapy.

Obrázok 5.2: Denníky pre predloženú aplikáciu MapReduce.

Výsledok úlohy 6

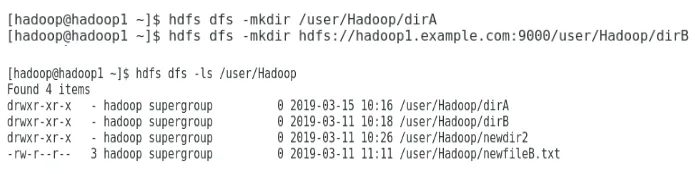

Obrázok 6 ukazuje, ako vytvoriť adresár v systéme súborov Hadoop a vykonať zoznam adresárov hdfs.

Obrázok 6: Vytvorenie adresára v systéme súborov Hadoop

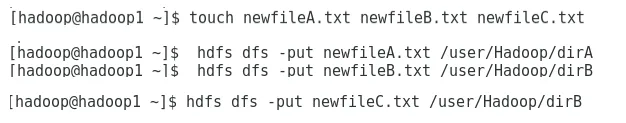

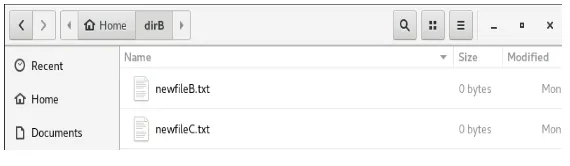

Obrázok 6.1 ukazuje, ako umiestniť súbor do distribuovaného systému súborov Hadoop a obrázok 6.2 zobrazuje vytvorený súbor v adresári dirB.

Obrázok 6.1: Vytvorenie súboru v HDFS.

Obrázok 6.2: Vytvoril sa nový súbor.

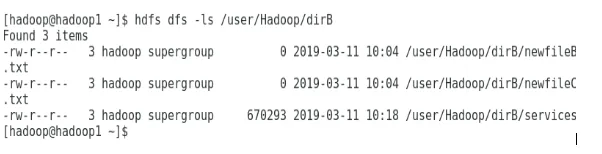

Niekoľko nasledujúcich obrázkov ukazuje, ako uviesť obsah jednotlivých adresárov:

Obrázok 6.3: Obsah dirA

Obrázok 6.4: Obsah dirB

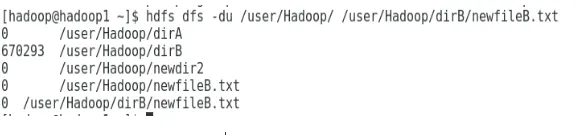

Nasledujúci obrázok zobrazuje spôsob zobrazenia veľkosti súborov a adresárov:

Obrázok 6.5: Zobrazenie veľkosti súboru a adresára.

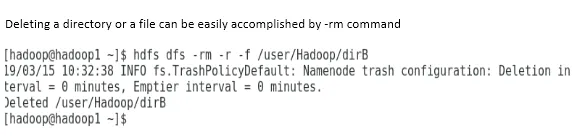

Odstránenie adresára alebo súboru je možné ľahko vykonať príkazom -rm.

Obrázok 6.6: Vymazanie súboru.

záver

Spoločnosť Big Data zohrala veľmi dôležitú úlohu pri formovaní dnešného svetového trhu. Hadoop framework zjednodušuje život analytikov údajov pri práci na veľkých množinách údajov. Konfigurácia Apache Hadoop bola pomerne jednoduchá a používateľské rozhranie online poskytovalo používateľovi viac možností na vyladenie a správu aplikácie. Hadoop sa v organizáciách masívne používa na ukladanie údajov, analytiku strojového učenia a zálohovanie údajov. Spravovanie veľkého množstva údajov bolo veľmi užitočné vďaka distribuovanému prostrediu Hadoop a MapReduce. Vývoj Hadoop bol v porovnaní s relačnými databázami celkom úžasný, pretože im chýbali možnosti ladenia a výkonu. Apache Hadoop je užívateľsky prívetivé a lacné riešenie pre efektívnu správu a ukladanie veľkých dát. HDFS tiež pomáha pri ukladaní údajov.

Odporúčané články

Toto je príručka na inštaláciu aplikácie Hadoop. Tu diskutujeme úvod k inštalácii Hadoopu, krok za krokom inštalácia Hadoopu spolu s výsledkami inštalácie Hadoop. Viac informácií nájdete aj v ďalších navrhovaných článkoch -

- Úvod do streamovania Hadoop

- Čo je klaster Hadoop a ako to funguje?

- Ekosystém Apache Hadoop a jeho komponenty

- Čo sú alternatívy spoločnosti Hadoop?