Úvod do príkazov Hadoop fs

V tomto článku si prejdeme príkazy na prácu so súbormi HADOOP, ktoré sa používajú na správu súborov prostredníctvom konzoly.

Budete potrebovať systém Linux a najnovšiu verziu Hadoop. Aby sme mohli vytlačiť verziu Hadoop, aby sme vedeli, pre koho bolo vydanie vydané, musíme skontrolovať hodnotu súčtu kontrolného súčtu, ktorú potrebujeme vykonať po prihlásení sa na platformu Hadoop.

Príkaz: Hadoop verzia

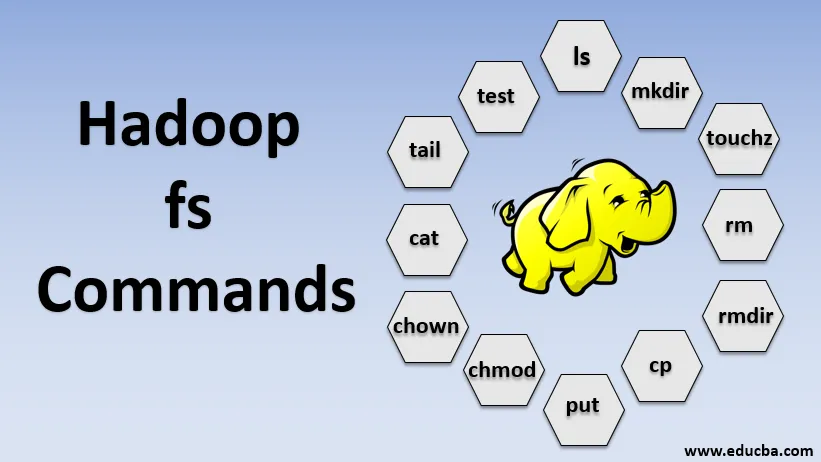

Príkazy Hadoop fs

Teraz sa naučme, ako používať príkazy HADOOP fs.

Začneme základmi. Stačí zadať tieto príkazy do PUTTY alebo do akejkoľvek konzoly, s ktorou ste spokojní.

1. hadoop fs -ls

V prípade adresára vráti zoznam súborov a adresárov, zatiaľ čo v prípade súboru vráti štatistiku súboru.

hadoop fs -lsr: slúži na rekurzívny výpis adresárov a súborov v konkrétnych priečinkoch.

- Príklad : hadoop fs -ls / alebo hadoop fs -lsr

- -d: Používa sa na zoznam adresárov ako obyčajných súborov.

- -h: Používa sa na formátovanie veľkostí súborov spôsobom, ktorý je čitateľný pre človeka, ako iba počet bajtov.

- -R: Používa sa na rekurzívny zoznam obsahu adresárov.

2. hadoop fs -mkdir

Tento príkaz berie cestu ako argument a vytvára adresáre v hdfs.

- Príklad : hadoop fs -mkdir / user / datahub1 / data

3. hadoop fs-touchz

Vytvára prázdny súbor a nevyužíva miesto

- Príklad: hadoop fs -touchz URI

4. hadoop fs -rm

Odstráňte súbory zadané ako argument. Ak chcete odstrániť celý adresár, musíme zadať voľbu -r. A ak je zadaná voľba -skipTrash, preskočí kôš a súbor bude okamžite odstránený.

- Príklad : hadoop fs -rm -r /user/test1/abc.text

5. hadoopfs-rmdir

Odstraňuje súbory a povolenia adresárov a podadresárov. V podstate sa jedná o rozšírenú verziu Hadoop fs -rm.

6. hadoop fs -cp

Skopíruje súbor z jedného miesta na druhé

- Príklad : hadoop fs -cp /user/data/abc.csv / user / datahub

7. hadoop fs -copyZ LOCcal

Skopíruje súbor z edgenode na HDFS.

8. hadoop fs -put

Skopíruje súbor z edgenode do HDFS, je podobný predchádzajúcemu príkazu, ale dá tiež prečíta vstup zo štandardného vstupu stdin a zapíše ho do HDFS

- Príklad : hadoop fs -put abc.csv / user / data

hadoop fs -put -p: Vlajka zachováva prístup, čas modifikácie, vlastníctvo a režim.

hadoop fs -put -f: Tento príkaz prepíše cieľ, ak súbor už existuje pred kópiou.

9. hadoop fs -moveFromLocal

Je to podobné kopírovaniu z lokálneho formátu s tým rozdielom, že zdrojový súbor sa po kopírovaní do systému HDFS odstráni z miestneho edgenodu

- Príklad : fs -moveFromLocal abc.text / user / data / acb.

10. hadoop fs -copyToLocal

Skopíruje súbor z HDFS do edgenode.

- Príklad : fs -copyToLocal abc.text / localpath

11. hadoop fs -chmod

Tento príkaz nám pomáha zmeniť prístup k súboru alebo adresáru

- Príklad : hadoop fs -chmod (-R) (cesta)

12. hadoop fs -chown

Tento príkaz nám pomáha zmeniť vlastníctvo súboru alebo adresára

- Príklad : hadoop fs -chown (-R) (OWNER) (:( GROUP)) PATH

13. hadoop fs -cat

Vytlačí obsah súboru HDFS na termináli

- Príklad : hadoop fs -cat /user/data/abc.csv

14. hadoop fs -tail

Zobrazuje poslednú KB súboru HDFS do stdout

- Príklad : hadoop fs -tail / in / xyzfile

15. hadoop fs -test

Tento príkaz sa používa pre testovacie operácie so súbormi HDFS, vráti 0, ak je pravdivé.

- - e: skontroluje, či súbor existuje.

- -z: skontroluje, či má súbor nulovú dĺžku

- -d / -f: skontroluje, či je cesta adresárom alebo súborom

Tu uvádzame podrobný príklad

- Príklad : hadoop fs -test - (defz) /user/test/test1.text

16. hadoop fs -du

Zobrazuje veľkosti súborov a adresárov v danom adresári alebo dĺžku súboru v prípade, že ide o súbor

17. hadoop fs -df

Zobrazuje voľné miesto

18. hadoop fs -checksum

Vráti informácie o kontrolnom súčte súboru

19. hadoop fs -getfacl

Zobrazuje zoznam riadenia prístupu (ACL) konkrétneho súboru alebo adresára

20. hadoop fs -count

Počíta počet adresárov, súborov a bajtov pod cestou, ktorá zodpovedá zadanému vzoru súboru.

21. hadoop fs -setrep

Zmení replikačný faktor súboru. A ak je cesta adresárom, príkaz zmení replikačný faktor všetkých súborov v adresári.

- Príklad : hadoop fs -setrep -R / user / datahub: používa sa na akceptovanie spätnej schopnosti a nemá žiadny účinok.

hadoop fs - setrep -w / user / datahub : čaká na dokončenie replikácie

22. hadoop fs -getmerge

Zreťazí súbory HDFS v zdroji do cieľového lokálneho súboru

- Príklad : hadoop fs -getmerge / user / datahub

23. hadoop fs -endendooile

Pripojí jeden zdroj alebo viac zdrojov z lokálneho systému súborov k cieľu.

- Príklad : hadoop fs -appendToFile xyz.log data.csv / in / appendfile

24. hadoop fs -stat

Vytlačí štatistiky o súbore alebo adresári.

- Príklad : hadoop fs -stat (formát)

Záver - príkazy Hadoop fs

Prešli sme teda takmer všetkými príkazmi, ktoré sú potrebné na prácu so súbormi, a prezeráme si údaje vo vnútri súborov. Teraz môžete upraviť svoje súbory a prijímať údaje do platformy Hadoop.

Odporúčané články

Toto je sprievodca príkazmi Hadoop fs. Tu diskutujeme o úvode príkazov Hadoop fs spolu s podrobným príkladom. Viac informácií nájdete aj v nasledujúcich článkoch

- Nainštalujte program Hadoop

- Hadoop Tools

- Hadoop Architecture

- Hadoop Components

- Hadoop fs Príkazy