Úvod do Hadoop Framework

Než sa hlbšie ponoríme do technického rámca Hadoopu, začneme jednoduchým príkladom.

Existuje farma, ktorá zberá paradajky a ukladá ich v jednom skladovacom priestore. Teraz so zvyšujúcim sa dopytom po zelenine začala farma zbierať zemiaky, mrkvu - so zvyšujúcim sa dopytom bol nedostatok poľnohospodárov, takže najali viac farmárov. Po nejakom čase si uvedomili, že v skladovacích priestoroch je nedostatok - preto distribuovali zeleninu do rôznych skladovacích priestorov. Pokiaľ ide o získavanie údajov, všetky pracujú súbežne s vlastným úložným priestorom.

Ako teda súvisí tento príbeh s veľkými údajmi?

Skôr sme mali obmedzené údaje, s obmedzeným procesorom a jednou úložnou jednotkou. Ale potom sa generovanie údajov zvýšilo, čo viedlo k veľkému množstvu a rôznym variantom - štruktúrované, pološtrukturované a neštruktúrované. Riešením bolo použitie distribuovaného úložiska pre každý procesor, čo umožnilo ľahký prístup k ukladaniu a prístupu k údajom.

Takže teraz môžeme nahradiť zeleninu ako rôzne druhy údajov a miesto na ukladanie dát ako distribuované miesta na ukladanie údajov a rôznych pracovníkov, ktorí sú každým spracovateľom.

Takže veľké dáta sú výzvou a Hadoop hrá úlohu v riešení.

Hadoop

1. Riešenie pre veľké dáta: pretože sa zaoberá zložitosťou veľkého objemu, rýchlosti a rozmanitosti údajov.

2. Súbor projektu s otvoreným zdrojom.

3. Spoľahlivo ukladá obrovské množstvo údajov a umožňuje obrovské distribuované výpočty.

4. Kľúčové atribúty spoločnosti Hadoop sú redundancia a spoľahlivosť (absolútne žiadna strata dát).

5. Zameriava sa predovšetkým na dávkové spracovanie.

6. Beží na komoditnom hardvéri - nemusíte kupovať žiadny špeciálny drahý hardvér.

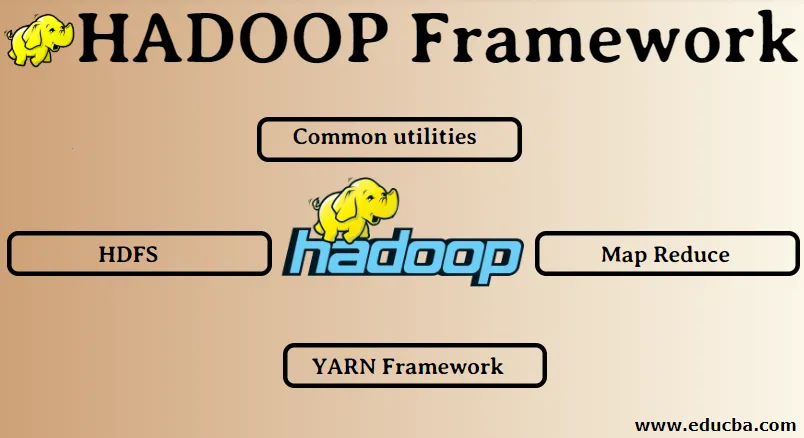

Hadoop Framework:

1. Bežné nástroje

2. HDFS

3. Mapa Zmenšiť

4. Rámec YARN

1. Bežné nástroje:

Tiež sa nazýva Hadoop obyčajný. Toto nie sú nič iné ako knižnice, súbory, skripty a pomocné programy JAVA, ktoré sú potrebné na vykonávanie ostatných komponentov Hadoop.

2. HDFS: Distribuovaný systém súborov Hadoop

Prečo sa spoločnosť Hadoop rozhodla začleniť distribuovaný systém súborov?

Poďme to pochopiť na príklade: Potrebujeme prečítať 1 TB dát a máme jeden stroj so 4 I / O kanálmi, pričom každý kanál má 100 MB / s, načítanie celých údajov trvalo 45 minút. Teraz číta rovnaké množstvo údajov 10 prístrojov, každý so 4 I / O kanálmi, pričom každý kanál má 100 MB / s. Hádajte, koľko času to trvalo na prečítanie údajov? 4, 3 minúty. HDFS rieši problém ukladania veľkých dát. Dve hlavné zložky systému HDFS sú NAME NODE a DATA NODE. Uzol mena je hlavný, môžeme mať aj sekundárny uzol názvu, ak primárny názov uzol prestane fungovať, uzol sekundárneho názvu bude fungovať ako záloha. Uzol názvu v podstate udržuje a spravuje dátové uzly ukladaním metadát. Dátový uzol je otrok, ktorý je v podstate lacným komoditným hardvérom. Môžeme mať viac dátových uzlov. Dátový uzol ukladá skutočné údaje. Tento dátový uzol podporuje replikačný faktor, predpokladajme, že ak jeden dátový uzol klesne, údaje môžu byť sprístupnené druhým replikovaným dátovým uzlom, preto je prístupnosť údajov zlepšená a je zabránené strate údajov.

3. Zmenšiť mapu:

Rieši problém spracovania veľkých dát. Pochopme, že koncept mapy sa zmenšuje riešením tohto problému v skutočnom svete. Spoločnosť ABC chce vypočítať svoj celkový predaj mestom. Teraz tu koncept hashovej tabuľky nebude fungovať, pretože údaje sú v terabajtoch, takže použijeme koncept Map-Reduce.

Existujú dve fázy: a) MAP. b) ZNÍŽENIE

a) Mapa : Najprv rozdelíme údaje na menšie kúsky nazývané mapovače na základe páru kľúč / hodnota. Kľúčom bude tu názov mesta a hodnota bude celkový predaj. Každý mapovač získa údaje za každý mesiac, ktoré obsahujú názov mesta a zodpovedajúci predaj.

b) Znížiť: Získa tieto hromady údajov a každý reduktor bude zodpovedný za mestá sever / západ / východ / juh. Takže práca reduktora bude zhromažďovať tieto malé kúsky a konvertovať na väčšie množstvá (ich pridaním) pre konkrétne mesto.

4.YARN Framework: Ešte jeden vyjednávač zdrojov.

Počiatočná verzia Hadoopu mala iba dve komponenty: Map Reduce a HDFS. Neskôr sa zistilo, že Map Reduce nedokáže vyriešiť veľa veľkých dátových problémov. Zámerom bolo zbaviť zodpovednosti za riadenie zdrojov a plánovania úloh zo starého motora na zníženie mapy a dať ho novému komponentu. Takto na snímku prišiel YARN. Je to stredná vrstva medzi HDFS a Map Reduce, ktorá je zodpovedná za správu zdrojov klastra.

Vykonávanie má dve kľúčové úlohy: a) Plánovanie úloh. b) Správa zdrojov

a) Plánovanie úloh: Ak dáva veľké množstvo údajov na spracovanie, je potrebné ich distribuovať a rozdeliť na rôzne úlohy / úlohy. Teraz JS rozhodne, ktorá úloha musí mať najvyššiu prioritu, časový interval medzi dvoma úlohami, závislosť medzi úlohami, skontroluje, či nedochádza k prekrývaniu medzi spustenými úlohami.

b) Správa zdrojov: Na spracovanie údajov a ich ukladanie potrebujeme zdroje, nie? Správca prostriedkov poskytuje, spravuje a udržiava prostriedky na ukladanie a spracovanie údajov.

Takže teraz máme jasno o koncepte Hadoopu a o tom, ako rieši problémy spôsobené veľkými údajmi !!!

Odporúčané články

Toto bol sprievodca Hadoop Frameworkom. Tu sme tiež diskutovali o najlepších 4 rámcoch Hadoop. Viac informácií nájdete aj v ďalších navrhovaných článkoch -

- Databáza Hadoop

- Hadoop ekosystém

- Použitie Hadoopu

- Úlohy administrátora Hadoop

- Administrátor Hadoopu Zručnosti a kariérna cesta